Variable not found

Enlaces interesantes 616

junio 30, 2025 06:29

De alguna forma, los desarrolladores somos como relojeros: construimos sistemas complejos utilizando piezas diminutas que van encajando armoniosamente unas con otras para formar una máquina que funciona como un todo y aporta valor a nuestros usuarios. Quizás por eso me ha llamado la atención un precioso y trabajado artículo interactivo de Bartosz Ciechanowski, al que he llegado a través de MicroSiervos, sobre cómo funcionan los relojes mecánicos.

Continuando con la serie "cómo funcionan las cosas", Mia Koring nos explica cómo funciona la compresión de texto usando el algoritmo de codificación Huffman, uno de los muchos que existen para que nuestros datos ocupen menos espacio.

También esta semana, Martin Fowler ha publicado una reflexión, que comparto totalmente, sobre cómo los LLMs tienen la capacidad de redefinir lo que entendemos como "programación". De la misma forma que el ensamblador nos alejó de los ceros y unos, o los lenguajes de alto nivel nos fueron aislando cada vez más de la máquina permitiéndonos jugar con abstracciones superiores, los LLMs son una capa de abstracción aún mayor, que incluso nos permite alejarnos de los detalles de implementación y centrarnos más en la lógica y el diseño de alto nivel... eso sí, a costa de la indeterminación. Un artículo muy interesante que no te puedes perder.

Por último, me ha alegrado leer en el post de David Ortinau que .NET 10 va a reducir la verbosidad del XAML usado en páginas y componentes MAUI, algo que siempre me ha parecido más farragoso de la cuenta... sobre todo cuando vienes de la web y usas sintaxis superconcisas como Razor.

El resto de contenidos interesantes recopilados la semana pasada, a continuación.

Por si te lo perdiste...

- Un ejemplo de uso elegante del operador "null coalescing assignment" de C#

José M. Aguilar - Extendiendo claims de usuarios en ASP.NET Core

José M. Aguilar

.NET

- Wire Up XUnit Logging for Crazy Integration Testing

Jeremy D. Miller - Legacy Code Survival Guide: Visual Basic and .NET in 2025

DeeDee Walsh - Task.WhenAll or Parallel.ForEach?

Fati Iseni - Day 11: Implementing a C# Mutation Operator for Genetic Algorithms

Chris Woodruff - Managing Secrets in .NET Applications with Azure Key Vault & Managed Identities

Sudhir Mangla - .NET 8.0.17 Upgrades, Forwarded Headers, and Unknown Proxy Issues

Khalid Abuhakmeh & Wesley Cabus - .NET Channels as a In-Memory Message Bus – Beware!

Derek Comartin

ASP.NET Core / ASP.NET / Blazor

- The Rise of Blazor: Architecting Modern Full-Stack Web Applications with C#

Sudhir Mangla - How to Add Error Bars to Blazor Charts: A Complete Guide with Examples

Sakthiviknesh Chellappa - You can't use switch expressions in Blazor (sometimes)

Steven Giesel - How to use lifetimes in ASP.NET Core dependency injection?

David Grace - .NET Aspire 1: What Is .NET Aspire?

Dave Brock - How to Build Multi-Tenant Reports in ASP.NET Core Applications

Alec Gall - .NET 10 Previews: Blazor Performance Monitoring, JS Interop

Jon Hilton

Conceptos / Patrones / Buenas prácticas

- Text Compression for Beginners (Huffman Coding)

Mia Koring - Backend for Frontend (BFF) Pattern Explained

Paul Williams

Data

- How I Optimized EF Core Query from 30 Seconds to 30 Milliseconds

Anton Martyniuk - Stop Using UUIDs in Your Database

Daniel Craciun

Machine learning / IA

- LLMs bring new nature of abstraction

Martin Fowler - Exposing PowerShell Universal as an MCP server to GitHub Copilot

Ironman Software

Web / HTML / CSS / Javascript

- Vite 7.0 is out!

Vite Team - A Better API for the Intersection and Mutation Observers

Zell Liew - Decoding The SVG path Element: Curve And Arc Commands

Myriam Frisano - Dependency Injection in JavaScript: A Functional Approach

Asmir Mustafic - Animating zooming using CSS: transform order is important… sometimes

Jake Archibald - Lightly Poking at the CSS if() Function in Chrome 137

Sunkanmi Fafowora - How to create light and dark color modes with CSS

Chris Ferdinandi - TypeScript: checking Map keys and Array indices

Axel Rauschmayer - Printing the web: making webpages look good on paper

Declan Chidlow - How We Reduced CKEditor’s Bundle Size by 40%

Filip Sobolinstal - Poking at the CSS if() Function a Little More: Conditional Color Theming

Daniel Schwarz - Tips for making regular expressions easier to use in JavaScript

Axel Rauschmayer - Enhance Formatting Efficiency with Format Painter in Vue Rich Text Editor

Thangavel E. - CSS Blob Recipes

Juan Diego Rodríguez - What's coming to JavaScript

Luca Casonato - Updates to my Table Sorting Web Component

Raymond Camden

Visual Studio / Complementos / Herramientas

- Más allá de los asistentes IA: GitHub lanza su Agente Autónomo para Copilot

CampusMVP - Google announces Gemini CLI: your open-source AI agent

Taylor Mulen & Ryan J. Salva - Working with stacked branches in git (Part 2)

Andrew Lock - Untrusted GIT repositories in Visual Studio

Bart Wullems - Better Models, Smarter Defaults: Claude Sonnet 4, GPT-4.1, and More Control in Visual Studio

Rhea Patel

.NET MAUI

- Simpler XAML in .NET MAUI 10

David Ortinau

Otros

- Mechanical Watch

Bartosz Ciechanowski

Publicado en Variable not found.

Navegapolis

El doble filo de la ambigüedad de la IA en las empresas ágiles

junio 27, 2025 10:36

En la comunidad ágil, recibimos con expectación la publicación de documentos como el “Scrum Guide Expansion Pack“. Un texto denso que intenta responder a los desafíos que plantea el uso de la inteligencia artificial. Pero la verdad es que es un cuchillo de doble filo: puede ser una guía de transformación genuina o la coartada perfecta para perpetuar viejos hábitos disfrazados de agilidad.

Dedica un gran esfuerzo a recordar que “lo humano es lo primero” y que la IA debe ser sólo un “aumento cognitivo”, pero al mismo tiempo se explaya en describir con detalle la eficiencia que aporta la inteligencia artificial.

Es inevitable preguntarse si en la práctica, la presión por los resultados no inclinará la balanza hacia la optimización y convertirá las buenas intenciones humanistas en discursos de bien quedar.

La encrucijada oculta en el mismo marco

Para la cultura de la empresa, el “Scrum Guide Expansion Pack” es un test de Rorschach, que refleja la que ya tiene. La empresa puede proyectar sus valores sobre el texto y encontrar, la confirmación que necesita para validar su enfoque.

Una organización centrada en las personas, busca en el texto la inspiración para validar o desarrollar su cultura de confianza, creatividad y desarrollo de personas y , por supuesto, la encuentra:

- Encuentra un liderazgo que sirve, no que manda: Confirma su creencia en un liderazgo de servicio al leer que su función es “…cultivar el entorno para los equipos Scrum autogestionados…“. Identifica el significado de nutrir y remover obstáculos, no dirigir ni controlar.

- Encuentra en la autogestión un motor de innovación al encontrar que los “Equipos Scrum autogestionados organizados en torno al valor son cruciales para la resolución creativa de problemas y la captura de la emergencia“. Valida que la autogestión es el camino para desatar el potencial colectivo ante la complejidad.

- Pone a la IA al servicio del talento humano, afianzando su visión de la tecnología como una palanca para las personas, al leer que la IA debe permitir que “…los miembros humanos del equipo Scrum se centren en consideraciones estratégicas, creativas y éticas“. La IA es un asistente que libera, no un sustituto que optimiza.

Pero al mismo tiempo, una organización con una cultura arraigada en la eficiencia, la predictibilidad y el control de procesos, busca en el mismo documento la justificación para perfeccionar y acelerar su maquinaria productiva y, también la encuentra:

- Encuentra en el Lean Thinking la coartada para la eficiencia extrema: El pensamiento lean “…reduce el desperdicio en el trabajo y en cómo se lleva a cabo…“. Desperdicio es todo lo que no sea producción directa, osea se pueden eliminar debates “innecesarios” y estandarizar procesos para maximizar el flow.

- Encuentra en la IA el camino hacia la automatización del control: Se entusiasma al leer que la IA puede “…actualizar y repriorizar los elementos del Product Backlog…” o que sus “…análisis basados en IA mejoran la transparencia, la inspección y la adaptación”, viendo aquí un consejo para reemplazar el juicio humano por algoritmos eficientes que optimizan el rendimiento a escala.

- Encuentra en la responsabilidad un mecanismo de conformidad: Define la profesionalidad de forma rígida al encontrar que los desarrolladores son “…colectivamente responsables de: Instaurar la calidad adhiriéndose y mejorando la definición de resultado terminado (Definition of Output Done)“. La responsabilidad se convierte en conformidad con la norma, y la calidad en una checklist que el sistema debe superar.

Para esta organización, la “agilidad” es un marco adecuado para modernizar el taylorismo, con un barniz vanguardista, sin alterar su núcleo de control y eficiencia.

Las dos organizaciones aplican el “Pack”, y en ambos casos el resultado es la intensificación la cultura que ya poseían.

Cuando el marco deja de ser un mapa y se convierte en un espejo

Un marco ambiguo puede funcionar como un espejo que refleja la cultura y las intenciones preexistentes. A una organización centrada en las personas, el marco valida y refuerza su enfoque, pero a una organización centrada en el producto, también.

Puede ser un eco de lo que ya es la organización y el peligro se hace más profundo cuando no se usa como espejo sino como máscara. Porque la ambigüedad permite adoptar la retórica de la agilidad centrada en las personas —”empoderamiento” , “autogestión” “seguridad psicológica”, etc. — para construir una fachada sin una realidad consecuente.

Las consecuencias: cinismo, estancamiento y devaluación

Para las personas, el cinismo de las organizaciones que predican el humanismo pero practican el taylorismo es agotador. Mata la confianza, la motivación y con ello: la creatividad.

Para la organización el resultado es una transformación estancada. Se adoptan los rituales, pero sin cambiar el ADN cultural, confundiendo la actividad con el progreso.

Y para la comunidad, el resultado es la devaluación del término “ágil”, que pierde su significado para convertirse en un conjunto de herramientas que cualquier cultura, puede adoptar.

La entrada El doble filo de la ambigüedad de la IA en las empresas ágiles se publicó primero en Navegápolis.

Picando Código

Desperdicio de bytes

junio 25, 2025 06:08

¿Alguna vez se pusieron a pensar en la cantidad de bytes que se desperdician en el trabajo?

El trabajo genera una cantidad inconmensurable de bytes desperdiciados en información que nadie nunca va a encontrar, y nadie nunca va a leer. Y si alguna persona curiosa o aventurera por casualidad se encuentra con ese contenido, generalmente va a estar desactualizado porque son pertinentes a sistemas o procesos que se abandonaron hace años. Se perdió esa energía y ese tiempo en crear esos bytes totalmente carentes de creatividad, utilidad o propósito. Tiempo y energía que se podría haber usado en algo mejor.

Es un ejercicio en futilidad, practicamos pretender que trabajamos para volvernos mejor en pretender que trabajamos. Es kafkiano, como tanto de lo que hace y define al mundo del trabajo corporativo.

Y ahí seguimos, haciendo nuestra parte y alimentando la distopía. Por lo menos a veces nos entretenemos distrayéndonos con estos pensamientos.

El post Desperdicio de bytes fue publicado originalmente en Picando Código.Variable not found

Esperar un segundo usando "await 1000" o "await TimeSpan.FromSeconds(1)" en vez de "await Task.Delay(1000)"

junio 24, 2025 06:05

Estamos acostumbrados a usar el operador await de C# para esperar la finalización de tareas asíncronas representadas por objetos de tipo Task, Task<T>, ValueTask o ValueTask<T>, pero, ¿sabíais que en realidad podemos usarlo con cualquier tipo de objeto?.

En este artículo vamos a ver que es bastante sencillo, y lo ilustraremos con un ejemplo muy simple: cómo esperar un segundo usando la expresión await 1000 o await TimeSpan.FromSeconds(1) en lugar del clásico await Task.Delay(1000).

¿Podemos awaitear cualquier objeto en .NET?

Pues sí, podemos utilizar await con cualquier tipo de datos, siempre que éste implemente el método GetAwaiter() de forna directa o mediante extensores. El objeto retornado por este método es donde realmente se lleva a cabo la magia de la ejecución asíncrona, y debe cumplir los siguientes requisitos:

- Implementar la interfaz

INotifyCompletion(o alguna interfaz descendiente, comoICriticalNotifyCompletion). Esto obliga a que, como mínimo, el objeto tenga un métodoOnCompleted()que reciba unActioncomo parámetro, que será el que se ejecute cuando la operación asíncrona haya terminado. - Tener un método

GetResult()que devuelva el resultado de la operación asíncrona (ovoidsi se trata de una tarea sin valor de retorno). - Tener una propiedad

IsCompletedque valgatruesi la operación asíncrona ha finalizado.

Fijaos que se trata de cumplir una interfaz implícita. No es necesario que el objeto retornado implemente la interfaz IAwaitable o algo similar, simplemente que disponga de un método GetAwaiter() que devuelva un objeto que cumpla con los requisitos. Si no es así, se generará un error en tiempo de compilación.

La implementación de objetos awaiters personalizados puede llegar a ser compleja, pero el framework ya nos proporciona clases que cumplen estos requisitos, como TaskAwaiter o ValueTaskAwaiter, que son los usados en los tipos que habitualmente utilizamos para operaciones asíncronas, como Task o ValueTask.

Por tanto, podemos aprovecharnos de esto para crear fácilmente clases cuyos objetos serán awaitables, como en el siguiente ejemplo:

public class Delayer

{

private readonly int _milliseconds;

public Delayer(int milliseconds)

{

_milliseconds = milliseconds;

}

public TaskAwaiter GetAwaiter()

{

return Task.Delay(_milliseconds).GetAwaiter();

}

}

Como podéis ver, no nos estamos complicando más de la cuenta: la clase implementa el método GetAwaiter(), pero en él retornamos simplemente el resultado de invocar al método GetAwaiter() de un objeto Task que se crea con Task.Delay(_milliseconds).

En la práctica, esto es suficiente para poder utilizar await con sus instancias:

var delayer = new Delayer(1000);

Console.WriteLine("Hello, world 1!");

await delayer; // Espera 1 segundo

Console.WriteLine("Hello, world 2!");

await new Delayer(2000); // Espera otros 2 segundos

Console.WriteLine("Hello, world 3!");

Pero ahora viene lo mejor: como adelantamos algo más arriba, GetAwaiter() puede ser también implementado como método extensor, por lo que no es necesario modificar la clase original. Esto nos permite virtualmente hacer un await sobre cualquier tipo de objeto, como vemos en el siguiente ejemplo, donde implementamos la extensión para el tipo int:

public static class IntExtensions

{

public static TaskAwaiter GetAwaiter(this int value)

{

return Task.Delay(value).GetAwaiter();

}

}

Hecho esto, ya seremos capaces de utilizar esta forma tan concisa para realizar esperas asíncronas:

await 1000; // Espera 1 segundo

var x = 2000;

await x; // Espera 2 segundos

¿Y si queremos esperar un tiempo determinado en lugar de un número de milisegundos? Pues también es posible, simplemente creando una extensión para el tipo TimeSpan:

public static class TimeSpanExtensions

{

public static TaskAwaiter GetAwaiter(this TimeSpan value)

{

return Task.Delay(value).GetAwaiter();

}

}

Así, ya podemos esperar el tiempo deseado usando directamente un TimeSpan:

await TimeSpan.FromHours(1); // Espera 1 hora

¡Misión cumplida! Ojo, no es que me parezca especialmente apropiado hacer algo así por aquello del Principio de la Mínima Sorpresa. Sin embargo, siempre es interesante saber que se puede hacer, más que nada porque nos llevará a entender mejor cómo funcionan algunos aspectos de C# y .NET que normalmente no manejamos en nuestro día a día.

Publicado en Variable not found.

Navegapolis

Agilidad en la encrucijada de la IA: ¿valor o personas?

junio 24, 2025 06:04

El Manifiesto Ágil redefinió el trabajo del conocimiento, al valorar a los “individuos y sus interacciones por encima de los procesos y las herramientas“. Durante más de dos décadas, este principio ha sido la estrella polar de los equipos que desarrollan en entornos complejos y volátiles (VUCA), en los que el valor lo aportan las personas. Pero ahora, la inteligencia artificial desafía esta situación y nos pone en una encrucijada.

La nueva realidad plantea una pregunta incómoda: en un mundo en el que la única inteligencia disponible es la humana, las personas, ¿son un fin en sí mismo o el medio para lograr el verdadero fin: el valor?

El Pacto Tácito: valor a través del bienestar

El paradigma de la producción está acotado entre dos extremos

- los entornos industriales, donde son los procesos y la tecnología los responsables de la calidad y del valor del resultado. Donde las personas actúan como operarios que “ayudan” o supervisan, para que se ejecuten correctamente.

- En el otro lado, en los entornos VUCA, caracterizados por la ambigüedad y el cambio constante. Donde la calidad y el valor del resultado depende del conocimiento tácito de las personas, ese que no puede ser explicitado en un proceso, y donde son los procesos y la tecnología los que “ayudan” y potencian el valor de las personas.

La agilidad entendió una verdad biológica: el talento y la creatividad humana dependen de factores emocionales como el estado de ánimo y la motivación. Para que “fluyan” es necesaria una cultura ágil en un entorno de trabajo centrado en el bienestar de las personas.

Esto nos lleva al dilema central: ¿Cuál es el objetivo de una empresa al apostar por la agilidad? ¿Las personas, y el valor que aportan es la consecuencia?, ¿o directamente el valor y para lograrlo tiene que desarrollar una cultura de bienestar? Hasta ahora la pregunta ha sido puramente filosófica, porque en los dos casos la respuesta es la misma: céntrate en las personas.

La Disrupción: cuando perdemos el monopolio de la inteligencia

Es probable que en poco tiempo la inteligencia artificial alcance el nivel general (AGI) y de capacidad “agéntica”, que rete lo que hasta ahora ha sido monopolio de la inteligencia humana. Pero no hace falta esperar a que esto ocurra (si finalmente ocurre). La actual generación de IA “estrecha” avanzada ya está ejecutando tareas complejas de conocimiento que eran dominio exclusivo del ser humano. Desde el análisis de datos en tiempo real hasta la generación de código o la validación acelerada de hipótesis. La IA ya puede conseguir eficiencia y optimización a una escala sin precedentes.

Esto convierte la pregunta filosófica de antes en una decisión de negocio crítica. Si el objetivo es maximizar el valor y la IA puede ofrecerlo sin el “coste” que implica la gestión el bienestar humano, la tentación de elegir esta ruta es muy atractiva.

La contradicción ya es palpable. Documentos como el “Scrum Guide Expansion Pack” dedican un gran esfuerzo a recordarnos que “lo humano es lo primero” y que la IA debe ser solo un “aumento cognitivo”. Pero al mismo tiempo se explayan con en describir con detalle la eficiencia que aporta la inteligencia artificial. Es inevitable preguntarse si en la práctica, la presión por los resultados no inclinará la balanza hacia la optimización y convertirá las buenas intenciones humanistas en discursos de bien quedar.

La pregunta de si el objetivo es el valor o las personas pone al descubierto la base de las dos formas de entender la agilidad. Lo que se viene denominando “hacer agilidad” o “ser ágil”

Hacer agilidad o agilidad técnica.

Consiste en un desarrollo iterativo e incremental para entregar valor temprano, frecuente y creciente, empleando el conocimiento del sistema, que antes de la IA estaba explicitado en el binomio de procesos y tecnología y ahora se le suma un tercer pilar: la inteligencia artificial. La premisa es la de los entornos industriales: “la calidad del resultado depende de la calidad de los procesos (y la tecnología)”.

Aquí las personas tienen un rol de asistencia. “Ayudan” o “asisten” a que el proceso tecnológico, ahora inteligente, se realice correctamente. Son los “humanos en el bucle” que validan las sugerencias de la IA, supervisan los algoritmos y corrigen las desviaciones del sistema optimizado. La agilidad aquí es sinónimo de velocidad, eficiencia y predictibilidad. Es el camino de la optimización, una ruta atractiva, fácil de justificar en un informe de resultados, pero que simplifica la agilidad a su esqueleto mecánico, despojándola del alma humanista.

Ser ágil o Agilidad completa.

Representa una reafirmación consciente de los principios originales. Es una “Agilidad completa” o humanista que, si bien también entrega valor temprano, de forma iterativa e incremental, lo hace desde un punto de partida opuesto.

Esta vía se aferra al principio de que la agilidad prefiere “a las personas y su interacción sobre los procesos y las herramientas”, incluso cuando las herramientas son redes neuronales capaces de proezas cognitivas. Aquí, el conocimiento que realmente importa sigue siendo el “tácito humano”, aquel que emerge de la experiencia, la colaboración, la intuición y la creatividad de un equipo de personas motivadas.

En este modelo, los procesos, la tecnología y la inteligencia artificial no son los protagonistas del sistema, sino los potenciadores del talento humano. La IA se convierte en un poderoso asistente que automatiza las tareas repetitivas, ofrece datos para enriquecer el debate, libera a las personas de la carga cognitiva trivial y permite al equipo centrarse en lo que los humanos hacemos de forma única: comprender el contexto del mundo físico real, empatizar con el cliente, negociar las complejidades políticas de un proyecto y, sobre todo, innovar de forma disruptiva.

Esta agilidad requiere, ahora más que nunca, “culturas ágiles” que proporcionen el bienestar y desarrollo personal. Porque si la IA puede replicar la inteligencia analítica, la ventaja competitiva humana residirá precisamente en su “naturaleza biológica / emocional”: la motivación, la curiosidad y un estado de ánimo positivo son las claves para que el talento pueda “fluir” y superar las soluciones algorítmicas.

¿Qué agilidad queremos?

La agilidad agilidad no se concreta por los avances de la IA, sino por las decisiones de los líderes. La elección entre un modelo “técnico” y uno “completo” no es una decisión tecnológica, sino una decisión estratégica y filosófica.

Podemos usar la IA para construir un taylorismo digital, una versión eficiente y optimizada de desarrollo de productos o podemos usarla para potenciar la inteligencia colectiva de los equipos.

¿Para qué queremos ser ágiles?

La entrada Agilidad en la encrucijada de la IA: ¿valor o personas? se publicó primero en Navegápolis.

Variable not found

Enlaces interesantes 615

junio 23, 2025 06:05

Una vez más, vamos con los contenidos interesantes recopilados durante la semana pasada 🙂

En esta ocasión, me vais a permitir a destacar un post propio que, aunque tiene más de un año de vida y es bastante básico, creo sigue siendo muy válido y puede ser de ayuda para algunos desarrolladores que siguen malgastando recursos. En "¡No uses ContainsKey() en un diccionario .NET para ver si existe un elemento antes de obtenerlo!" demostramos de forma empírica lo absurdo de realizar una comprobación de existencia de un elemento en un diccionario .NET antes de obtenerlo, un detalle en los que a veces no caemos.

También destacaremos algunos contenidos relacionados con MCP, que sin duda es la palabra de moda de los últimos tiempos. Primero, Aaron Stannard nos cuenta en qué consiste este estándar y para qué podamos usarlo en la práctica, eliminando el hype que le rodea.

Juan Luis Guerrero continúa explorando la implementación y uso de servidores MCP, esta vez usando como modelo Google Gemini 2.5.

Rhea Patel nos cuenta que el modo agente ya está disponible de forma general en Visual Studio.

Y el equipo de Visual Studio Code ha publicado un catálogo de servidores MCP listos para usar en el modo agente del editor, instalables con un único click.

El resto de enlaces, a continuación.

Por si te lo perdiste...

- ¡No uses ContainsKey() en un diccionario .NET para ver si existe un elemento antes de obtenerlo!

José M. Aguilar - Renderizar una vista Razor a un string en ASP.NET Core MVC

José M. Aguilar

.NET

- .NET 10 Performance Edition

Steven Giesel - Song recommendations from C# combinators

Mark Seemann - Getting started with Open Telemetry in .NET with Jaeger and Seq

Anton Martyniuk - 16 common mistakes C#/.NET developers make (and how to avoid them)

Ali Hamza Ansari - Temporal.IO in .NET

Marek Sirkovský - RunJS: An MCP server that lets LLMs generate and execute JavaScript safely in an embedded .NET runtime sandbox using the Jint library.

Charles Chen - 7 Underrated C# 12 and C# 13 Features Every Developer Should Know!

Saravanan Madheswaran - Kickstarting your libraries with the .NET Library Starter Kit Dennis Doomen

Dennis Doomen - How to use frozen collections in C#

Joydip Kanjilal - Unpacking Zip Folders into Windows Long File Paths

Rick Strahl

ASP.NET Core / ASP.NET / Blazor

- Send and Receive RCS Suggested Replies with ASP.NET Core and Vonage

Benjamin Aronov - Blazor Basics: Third-Party APIs in Blazor WebAssembly

Claudio Bernasconi - Implementing Rate Limiting in .NET with Redis Easily

Hamed Salameh

Conceptos / Patrones / Buenas prácticas

- 5 Mistakes That Make Your Code Unmaintainable

Derek Comartin

Data

- 8 EF Core Query Hacks to Supercharge Your App’s Performance

Gibran Fahed - Replacing a Column in a Large Active SQL Server Table

Matt Gantz - Using SQL Server 2025 Vector Search in .NET Aspire – eShopLite Style!

Bruno Capuano

Machine learning / IA

- Extending Semantic Kernel with MCP and Google Gemini: Real‑Time Weather Agent

Juan Luis Guerrero - Best 5 Open-Source LLMs for Developers: ChatGPT Alternatives in 2025

Jegan R. - Matrix Inverse Using Cayley-Hamilton with C#

James McCaffrey - Remote MCP support in Claude Code

Anthropic - Introduction to Semantic Kernel: The .NET Developer’s Guide to Building Powerful AI Agents

Sudhir Mangla - Model Context Protocol, Without the Hype

Aaron Stannard - Fine-Tuning LLMs with C#: Practical Guide for Custom Models Using ML.NET

Sudhir Mangla

Web / HTML / CSS / Javascript

- Cambio en la especificación de HTML: Escape de < y > en los atributos | Blog | Chrome for Developers

ichał Bentkowski - Things to avoid in JavaScript

Suren Enfiajyan - Angular 19 Standalone Components: Build Faster, Simpler Apps Without NgModules

Ankit Sharma - A Better API for the Resize Observer

Zell Liew - What I Wish Someone Told Me When I Was Getting Into ARIA

Eric Bailey - Controlling spacing in modern CSS layouts

Chris Ferdinandi - Visualize Workforce Data with Interactive React Drill-Down Charts

Sabari Anand S - How to Keep Up With New CSS Features

Sacha Greif - How to create a mesh gradient generator in HTML, CSS and JavaScript

Esther Vaati - An Introduction to Linked Signals in Angular

Christian Nwamba - How to Work with Queues in TypeScript

Yazdun - JSON module scripts are now Baseline Newly available

Thomas Steiner - Bluesky Likes Web Components • Lea Verou

Lea Verou - CSS Color Functions

Sunkanmi Fafowora - CSS Cascade Layers Vs. BEM Vs. Utility Classes: Specificity Control

Victor Ayomipo - How TypeScript solved its global

Iteratorname clash

Axel Rauschmayer - Color Everything in CSS

Juan Diego Rodríguez - Angular Signals: A New Mental Model for Reactivity, Not Just a New API

Sonu Kapoor

Visual Studio / Complementos / Herramientas

- 12 GitLens Features that Revolutionized My Coding Workflow in VS Code

Hichem Fantar - Agent mode is now generally available with MCP support

Rhea Patel - Working with stacked branches in git (Part 1)

Andrew Lock - Highlights from Git 2.50

Taylor Blau - 5 tips for using GitHub Copilot with issues to boost your productivity

Klint Finley - GitHub Copilot Spaces: Bring the right context to every suggestion

Andrea Griffiths - VS Code: MCP Servers for agent mode

VS Code Team - Copilot Compared: Advanced AI Features in Visual Studio 2022 vs. VS Code

David Ramel

.NET MAUI

- Multimodal Vision Intelligence with .NET MAUI

David Ortinau - Create a Sleek Contact Management App in .NET MAUI Using ListView and DataForm

Jayaleshwari N.

Variable not found

Evitar el aviso de compilación "NETSDK1057: You are using a preview version of .NET" usando global.json

junio 20, 2025 06:57

Si os gusta trastear con las previews de .NET en el mismo equipo en el que estáis desarrollando proyectos que usan versiones estables, es posible que al compilar encontréis en la consola o ventana Output de vuestro IDE favorito un mensaje de error parecido al siguiente:

NETSDK1057: You are using a preview version of .NET. See: https://aka.ms/dotnet-support-policy

Básicamente, el sistema nos está informando de que estamos usando un SDK que aún está en fase de pruebas, o preview. Aunque esto no debería ser un problema porque el SDK debería ser totalmente compatible hacia atrás, simplemente es un recordatorio de que no es la versión estable y siempre podríamos encontrarnos algún problema.

Esto ocurre porque los comandos del SDK utilizan la última versión instalada en el equipo, por lo que, si hemos instalado una versión preliminar, será ésta la que se utilice. Podemos comprobarlo fácilmente ejecutando el siguiente comando en consola, que nos mostrará la versión del SDK que se está utilizando por defecto:

C:\> dotnet --version

10.0.100-preview.5.25277.14

Normalmente, el mensaje NETSDK1057 podemos ignorarlo sin problema, pero si por cualquier motivo queremos eliminarlo o simplemente queremos forzar el uso de una versión determinada del SDK de .NET en algún proyecto o de forma global, podremos hacerlo usando un archivo llamado global.json.

Forzar la versión del SDK

Para forzar el uso de una versión específica del SDK de .NET, bien sea de forma global o bien en un proyecto concreto, lo primero que debemos hacer es determinar qué versiones del SDK tenemos instaladas en nuestro equipo. Para ello, podemos ejecutar el siguiente comando en la consola:

C:\> dotnet --list-sdks

2.1.818 [C:\Program Files\dotnet\sdk]

3.1.426 [C:\Program Files\dotnet\sdk]

6.0.301 [C:\Program Files\dotnet\sdk]

6.0.321 [C:\Program Files\dotnet\sdk]

7.0.120 [C:\Program Files\dotnet\sdk]

8.0.117 [C:\Program Files\dotnet\sdk]

8.0.206 [C:\Program Files\dotnet\sdk]

8.0.411 [C:\Program Files\dotnet\sdk]

9.0.301 [C:\Program Files\dotnet\sdk]

10.0.100-preview.5.25277.14 [C:\Program Files\dotnet\sdk]

Una vez sabemos qué versiones del SDK tenemos instaladas y cuál queremos forzar, lo siguiente es crear un archivo llamado global.json. Su ubicación es importante, porque su ámbito se extiende a todos los proyectos que estén en la misma carpeta o en sus subdirectorios a cualquier nivel de profundidad.

Es decir, si creamos el archivo global.json en la raíz de un proyecto, afectará únicamente a ese proyecto y a sus subproyectos. Si lo creamos en una carpeta superior, por ejemplo en la carpeta de una solución, afectará a todos sus proyectos, que típicamente se encontrarán en subdirectorios. Si lo creamos en la carpeta raíz de un disco duro, afectará a todos los proyectos guardados en él.

El archivo global.json es un archivo JSON con una estructura muy sencilla (podéis consultarla siguiendo este enlace). Básicamente en él indicaremos la versión del SDK que queremos forzar a los proyectos que se encuentren en su ámbito, así como algunas opciones adicionales para personalizar su comportamiento.

Veamos un ejemplo sencillo. Si queremos forzar el uso de la versión 9.0.301 en un proyecto, basta con crear el archivo global.json en su raíz con el siguiente contenido:

{

"sdk": {

"version": "9.0.301"

}

}

La propia CLI de .NET también nos permite hacerlo usando el comando dotnet new global.json --sdk-version <version>, que creará el archivo global.json en la carpeta actual, forzando la versión del SDK que le indiquemos. El contenido del archivo creado será exactamente el mismo que el del ejemplo anterior:

C:\MyProject>dotnet new global.json --sdk-version 9.0.301

The template "global.json file" was created successfully.

C:\MyProject>type global.json

{

"sdk": {

"version": "9.0.301"

}

}

En cualquiera de los casos, si sobre la misma carpeta o alguna de sus subcarpetas consultamos el SDK utilizado por defecto, obtendremos el valor esperado:

C:\MyProject>dotnet --version

9.0.301

C:\MyProject>md Test

C:\MyProject>cd Test

C:\MyProject\Test>dotnet --version

9.0.301

A partir de este momento, dado que ya no estamos usando la versión preview del SDK, el mensaje de aviso habrá desaparecido 😊

Posibles efectos secundarios

Sin duda, usar global.json es una forma muy sencilla de forzar una versión del SDK de .NET en un proyecto o en un conjunto de proyectos. Sin embargo, al hacerlo también podemos estar introduciendo algunos inconvenientes que debemos considerar.

En primer lugar, si forzamos una versión del SDK que no está instalada en el equipo, obtendremos un error al intentar compilar o ejecutar el proyecto. Normalmente no ocurrirá en casos de desarrolladores aislados o si se hace de forma global, pero pueden surgir problemas si trabajamos en un equipo de desarrollo y alguno de los miembros no tiene instalada la versión del SDK que hemos forzado, pues se encontrará con el error al intentar compilar el proyecto.

Por ejemplo, si forzamos en el global.json el uso del SDK 9.0.400, que no está instalado en el equipo, al intentar compilar el proyecto obtendremos un error similar al siguiente:

C:\MyProject>dotnet build

The command could not be loaded, possibly because:

* You intended to execute a .NET application:

The application 'build' does not exist or is not a managed .dll or .exe.

* You intended to execute a .NET SDK command:

A compatible .NET SDK was not found.

Requested SDK version: 9.0.400

global.json file: C:\MyProject\global.json

También debemos tener en cuenta que al forzar una versión específica del SDK, podemos estar limitando el uso de nuevas características o mejoras que se vayan introduciendo en versiones posteriores del SDK. Es decir, si la versión estable actual es la 9.0.301 y se lanza la 9.0.400, no pasaremos a usar esta última de forma automática, será necesario actualizar el global.json para referenciar la nueva versión.

Por último, a la hora de forzar una versión del SDK, sobre todo si se hace de forma global, también es importante tener en cuenta que cada versión del SDK admite un conjunto de versiones del runtime de .NET. Por ejemplo, si forzamos el uso del SDK 9.0.301, no podremos compilar o ejecutar proyectos cuyo <TargetFramework> en el archivo .csproj sea superior a net9.0, como net10.0 o posteriores:

C:\MyProject>dotnet build

C:\Program Files\dotnet\sdk\9.0.301\Sdks\Microsoft.NET.Sdk\targets\Microsoft.NET.TargetFrameworkInference.targets(166,5): error NETSDK1045: The current .NET SDK does not support targeting .NET 10.0. Either target .NET 9.0 or lower, or use a version of the .NET SDK that supports .NET 10.0. Download the .NET SDK from https://aka.ms/dotnet/download

Cómo forzar la última versión estable

Afortunadamente, muchos de estos problemas podemos solucionarlos usando opciones adicionales en el archivo global.json.

Por ejemplo, si queremos que el SDK use la última versión estable instalada en el equipo, sea cual sea su número de versión, podemos usar la opción allowPrerelease. Dado que no usamos la propiedad version para especificar una versión concreta, el sistema simplemente buscará la más reciente que no sea preview:

{

"sdk": {

"allowPrerelease": false

}

}

El valor por defecto de

allowPrereleasepuede variar según el entorno. En la CLI suele sertrue, pero si estamos en Visual Studio, depende de lo que hayamos configurado en la secciónHerramientas>Opciones>Entorno>Características de versión preliminar.

Adicionalmente, existe la propiedad rollForward, que nos permite controlar cómo se comporta el SDK cuando no existe la versión del SDK que hemos especificado en la propiedad version, o cómo actuar si existen versiones posteriores a la especificada. Pero esto, si os interesa, lo veremos en un artículo posterior, y mientras tanto, podéis consultar la documentación oficial para más detalles.

Conclusión

En resumen, el uso de global.json nos permite tener un control preciso sobre la versión del SDK de .NET utilizada en nuestros proyectos, evitando sorpresas y mensajes de advertencia relacionados con versiones preliminares. Sin embargo, es importante conocer sus implicaciones y utilizarlo de forma consciente, especialmente en entornos colaborativos.

¡Espero que os resulte útil!

Navegapolis

Córcholis

junio 18, 2025 05:55

Hace unos meses anduve explorando (y alucinando) las posibilidades de programación y vibe-coding con IA.

Me enganchó, y esto es lo que hice. Si tenéis hijos, sobrinos, nietos lo dejo ahí de regalo

La entrada Córcholis se publicó primero en Navegápolis.

Variable not found

Enlaces interesantes 614

junio 16, 2025 03:39

Buena cosecha la semana pasada, con mucho contenido interesante 🙂

Destacamos el lanzamiento de la quinta preview de .NET 10, que esta vez incluye cambios en C#, ASP.NET Core, Blazor, .NET MAUI y otras áreas.

Rick Strahl nos enseña a añadir paquetes NuGet en tiempo de ejecución a una aplicación, algo que puede ser muy útil en sistemas con plugins o extensiones.

Vale la pena también echar un vistazo a Next Edit Suggestions, una nueva característica de GitHub Copilot para Visual Studio y Code que sugiere la siguiente edición en el código, lo que puede mejorar la productividad de los desarrolladores.

Shalitha Suranga comparte sus reflexiones sobre el declive de los blogs técnicos y cómo los desarrolladores somos los únicos que podemos hacer algo para que no desaparezcan.

Finalmente, Ricardo Peres nos presenta RazorSharpener, un componente que simplifica la compilación y renderización de componentes Razor en tiempo de ejecución.

Más contenidos interesantes, a continuación.

Por si te lo perdiste...

- Procesar secuencias por lotes, o cómo usar chunks en C#

José M. Aguilar - Autenticación JWT en APIs con ASP.NET Core

José M. Aguilar

.NET

- .NET 10 Preview 5

James Montemagno - Adding Runtime NuGet Package Loading to an Application

Rick Strahl - Don't reinvent the wheel

Josef Ottosson - Federated Identity in .NET: A Complete Guide for Software Architects

Sudhir Mangla - Converting a Microsoft XNA 3.1 game to MonoGame

Andrew Lock - How to Create and Convert PDF Documents in ASP.NET Core

Anton Martyniuk - Are Your LINQ Queries Slowing Down Your App? Here's How to Fix Them

Meena Alagiah - Repeating a test multiple times in C#

Bart Wullems - C# Tip: Handling exceptions with Task.WaitAll and Task.WhenAll

Davide Bellone - Queue-Based Load Leveling Pattern in C#: Cloud Stability, Scalability & Best Practices

Sudhir Mangla - Domain-Driven Design Principles: Value Objects in ASP.NET Core

Assis Zang - Run C# Scripts With dotnet run app.cs (No Project Files Needed)

Milan Jovanović

ASP.NET Core / ASP.NET / Blazor

- ASP.NET Core in .NET 10 Preview 5

ASP.NET Core Team - Introducing RazorSharpener

Ricardo Peres - API contracts and nullability in ASP.NET Core

Bart Wullems - Transforming Microservices Development with .NET Aspire: A Real-World Implementation

Sogue - Making a header parameter required in ASP.NET Core

Bart Wullems - Fantastic Alert Messages Using SweetAlert

Héctor Pérez

Azure / AWS / Cloud

- Unlocking the Cloud: How to Seamlessly Migrate On-Prem File Shares to Azure Storage

Chris Pietschmann - AWS Introduces Open Source Model Context Protocol Servers for ECS, EKS, and Serverless

Steef-Jan Wiggers

Conceptos / Patrones / Buenas prácticas

- Como funciona un contenedor de inyección de dependencias

Fran Iglesias - Mastering the Factory Pattern in C# 13: Best Practices with Real-World Examples

Ziggy Rafiq - 10+ Signs You Might Need API Governance

Bill Doerrfeld - You DON’T Need Microservices for Serverless!

Derek Comartin

Data

- Debunking the "Filter Early, JOIN Later" SQL Performance Myth

Milan Jovanović

Machine learning / IA

- Choosing the right AI model for your task

GitHub - Open-sourcing circuit-tracing tools

Anthropic - Building smarter AI Agents with Semantic Kernel

Neel Bhatt

Web / HTML / CSS / Javascript

- What’s New in Angular 20?

Mydeen S. N. - Creating an Auto-Closing Notification With an HTML Popover

Preethi - Decoding The SVG path Element: Line Commands

Myriam Frisano - Creating The “Moving Highlight” Navigation Bar With JavaScript And CSS

Blake Lundquist - How to import() a JavaScript String

Zach Leatherman - 4 common layouts made easy with modern CSS

Chris Ferdinandi - Getting Started with the httpResource API in Angular

Dhananjay Kumar - The cluster layout with modern CSS

Chris Ferdinandi - Breaking Boundaries: Building a Tangram Puzzle With (S)CSS

Sladjana Stojanovic - The split layout with modern CSS

Chris Ferdinandi - Smarter Angular: AI at the Edge of the Framework

Alyssa Nicoll - The stack layout in modern CSS

Chris Ferdinandi - Angular v20 might seem boring — Here are 6 reasons it’s not

Yan Sun - A Pure SVG Circular Component

Jonathan Gamble

Visual Studio / Complementos / Herramientas

- Next edit suggestions available in Visual Studio GitHub Copilot

Sławek Rosiek - Security and Trust in Visual Studio Marketplace

Sean Iyer - AI Toolkit for VS Code June Update

Junjie Li - SQL and NoSQL Query langauge support come to ReSharper!

Rachel Appel - Improve Your Productivity with New GitHub Copilot Features for .NET!

Leslie Richardson - The Complete MCP Experience: Full Specification Support in VS Code

Harald Kirschner, Connor Peet, & Tyler Leonhardt

.NET MAUI

- .NET MAUI Updates in .NET 10 Preview 5

David Ortinau - Writing NFC Tags in .NET

Peter Foot - Multimodal Voice Intelligence with .NET MAUI

David Ortinau - Build AI-Powered Smart Sales Dashboards with .NET MAUI Charts

Saiyath Ali Fathima M. - Boost .NET MAUI App Performance: Best Practices for Speed and Scalability

Jayaleshwari N. - Examining APIs in .NET MAUI Community Toolkit Essentials

Héctor Pérez

Otros

- Surviving the Great Commoditizer: Stop Getting ‘Good’ at ChatGPT

Erik Dietrich - Apple supercharges its tools and technologies for developers

Apple - Technical Blogging is Dying. Programmers, let’s save the dying…

Shalitha Suranga

Publicado en Variable not found.

Picando Código

Script Ruby para elegir una transmisión en vivo del canal oficial de los Power Rangers en YouTube y abrirlo en VLC

junio 10, 2025 02:17

El canal oficial de Power Rangers en YouTube tiene tres transmisiones en vivo diarias. También tiene un montón de material como los episodios completos y temporadas enteras de la serie clásica y sucesivas versiones. A veces está bueno engancharse a mirar una de estas transmisiones. Es como emular la forma en que uno miraba televisión en otras épocas, prendíamos la tele y mirábamos lo que había, sin tener idea el número de temporada o episodio.

Procrastinando una noche en la que debía acostarme temprano para estar bien descansado para un evento que me venía produciendo bastante ansiedad, me puse a programar el siguiente script. Seguramente haya mejores maneras de hacer esto, más eficientes, y hasta más cómodas. Pero no es el punto, el ejercicio de definir un objetivo y lograrlo, por más intrascendente, ineficiente o innecesario que sea, a veces es una necesidad para apagar las voces de esos fantasmas que cargamos con nosotros. Ese esfuerzo ayuda a darle algo de significado a esos minutos vividos y compartirlo por este medio con suerte genere alguna reacción o conexión con la persona del otro lado de la pantalla. O al menos entretiene y distrae.

Es un script en Ruby que usa Nokogiri y OpenURL para descargar la página inicial de "en vivo" de Power Rangers en YouTube. De ahí, parsea los tres más nuevos. Por lo que he visto hasta ahora, son los que están "activos", y después van quedando archivados. Una vez obtenido el id del video, ejecuta VLC en pantalla completa y reproduce el stream desde YouTube (sin anuncios ni cookies y demás).

Lo comparto acá por si a alguien más le resulta útil o de repente inspira a usar algo de esto en otra cosa:

gemfile do

source 'https://rubygems.org'

gem 'nokogiri'

gem 'debug'

end

require 'json'

require 'nokogiri'

require 'open-uri'

url = 'https://www.youtube.com/@PowerRangersOfficial/streams'

doc = Nokogiri::HTML5(URI.open(url))

data = doc.xpath("//script").find do |c|

c.children&.first&.text&.include?('var ytInitialData')

end.text

data.gsub!('var ytInitialData = ', '')

data.gsub!(/;$/, '')

coso = JSON.parse(data)

lives = coso['contents']['twoColumnBrowseResultsRenderer']['tabs'].find do |tab|

tab['tabRenderer']['title'] == 'Live'

end

# Elegir uno al azar de los últimos 3

id = lives['tabRenderer']['content']['richGridRenderer']['contents'][(0..2).to_a.sample]['richItemRenderer']['content']['videoRenderer']['videoId']

# Elegir el stream con el título "Best Episodes" para mirar un compilado de mejores episodios

id = lives['tabRenderer']['content']['richGridRenderer']['contents'].find do |live|

live['richItemRenderer']['content']['videoRenderer']['title']['runs'][0]['text'].include? 'Best Episodes'

end['richItemRenderer']['content']['videoRenderer']['videoId']

system("vlc -f https://www.youtube.com/watch?v=#{id}")

En principio tuve que parsear el HTML, y después encontrar una etiqueta script que contuviera el código var ytInitialData. Aparentemente esa variable JavaScript ytInitialData es la que guarda toda la información que usa la página web para mostrar los videos. Está en formato JSON, así que no tenía que andar haciendo encantamientos mágicos para manipular el texto. Accedí al texto dentro de las etiquetas, eliminé la parte inicial var ytInitialData = y el ; al final, y me quedaban llaves que definían JSON que pude parsear con JSON.parse en Ruby. Ahí ya podía empezar a navegar por llaves de Hashes hasta llegar al id del video. Como se ve en el código, está enterrado dentro de un montón de información, pero con un poco de debugging y prueba y error, lo encontré.

Algo interesante fue que programé este script en mi televisor, donde tengo una computadora conectada. Tengo Emacs "de fábrica", porque nunca me tomé el tiempo de configurarlo. Quién sería tan estúpido de ponerse a programar directamente en esa tele cuando puedo acceder con mi laptop por SSH... ¡YO! Me pareció divertido programar directamente e ir probando el resultado. De ahora en más los scripts los voy a mantener en la laptop para programar más cómodo...

Bonus track: Pokémon

El canal de Pokémon TV en YouTube tiene los mismos estilos de transmisión en vivo con capítulos de la serie animada. Hay uno en inglés y otro ¡en Español de Latinoamérica! También cuentan con un montón de listas de reproducción con temporadas completas, en varios idiomas, incluido también Español de Latinoamérica. Por lo tanto, se podría hacer algo similar, aunque aparentemente la id del video no cambia tanto, por lo que tengo un acceso directo (archivo .desktop) en mi escritorio con el siguiente código:

Encoding=UTF-8

Version=1.0

Type=Application

Terminal=false

Exec=vlc -f https://www.youtube.com/watch?v=-UzJLeNuils

Name=Pokémon TV

Icon=/home/fernando/Documents/pokemontv.jpg

Al hacer clic, se abre VLC en pantalla completa con el parámetro -f de línea de comando y reproduce la URL de YouTube que le paso. También, si uno quisiera "archivar" estos videos ofrecidos gratis y públicos, para mirarlos más tarde desde un dispositivo donde no contamos con conexión a internet, o tenerlos de respaldo en caso de que se caiga internet, o YouTube haya dejado de existir, o vivamos en un mundo post-apocalíptico donde no hay Internet pero sí suficiente electricidad de sobra como para usarla en computadoras como medio de entretenimiento y quisiéramos volver a mirar capítulos de Pokémon para recordar nuestras infancias y escapar de esta distópica realidad por unos meros minutos, uno podría ejecutar yt-dlp_linux --audio-multistreams -f bestvideo+bestaudio+233-3 https://www.youtube.com/playlist?list=PLRcHmntfmJ8CnSmj4C284-a1euH518aQa en la terminal para obtener todos los capítulos de la primera temporada con doble pista de audio en inglés y español de Latinoamérica.

Me gusta esto de programar cosas que puedo usar en la tele, hace unos años creé un control remoto web para volúmen. Otro proyecto totalmente innecesario, pero muchas veces es más importante probar que algo funciona, que su eventual utilidad. Debería reveer ese proyecto para ver cómo lo implementaría éstos días

Variable not found

Determinar el modo de renderización de un componente Blazor (versión 9 y posteriores)

junio 10, 2025 06:05

Desde la aparición de Blazor y sus distintos tipos de hosting de componentes (SSR, Server, WebAssembly), se intentó promover que estos fueran agnósticos respecto a su modo de ejecución. Sin embargo, en la práctica esto no es siempre posible, y en ocasiones necesitamos saber en qué modo se está ejecutando un componente para poder adaptarlo a las necesidades de la aplicación.

Hace más de un año, cuando aún Blazor 8 era la versión más reciente de este framework, vimos por aquí un truco para detectar si un componente Blazor estaba ejecutándose de forma estática (SSR) o interactiva. Y algunos años antes, ya habíamos visto también distintas formas para detectar si un componente interactivo estaba corriendo sobre Blazor Server o Blazor WebAssembly.

Aunque las soluciones propuestas funcionaban bien y solucionaban nuestro problema, eran simplemente trucos (o "hacks", algo retorcidos en algunos casos) para cubrir unas necesidades que no estaban bien resueltas desde el propio framework.

Con .NET 9 esto cambió, y desde esta versión de Blazor ya existen mecanismos nativos para detectar cuándo un componente se ejecuta en modo estático o interactivo, y en este último caso, qué modo de renderizado se está utilizando.

Vamos a ver cómo conseguirlo.

La propiedad RendererInfo

La propiedad RendererInfo de la clase ComponentBase, y por tanto accesible desde cualquier componente Blazor, permite obtener información sobre el renderizador que está utilizando el componente en el momento de consultarla.

Esta propiedad devuelve un objeto de tipo RendererInfo, definido por Blazor en el espacio de nombres Microsoft.AspNetCore.Components de la siguiente forma:

public sealed class RendererInfo(string rendererName, bool isInteractive)

{

public string Name { get; } = rendererName;

public bool IsInteractive { get; } = isInteractive;

}

La propiedad Name indica el nombre del renderizador que se está utilizando, que puede ser "Server", "Static" o "WebAssembly".

Por otra parte, la propiedad IsInteractive indica si el renderizador es interactivo o no. En el caso de Blazor Server y Blazor WebAssembly, esta propiedad será true, mientras que en el caso de Blazor SSR (renderización estática, no interactiva), será false.

Vamos a ver un ejemplo de su uso. El siguiente componente Counter.razor muestra la clásica página con el contador que encontramos en las plantillas de proyecto Blazor, aunque en esta ocasión, modificamos el atributo disabled del elemento en función de si el componente se está renderizando de forma interactiva o no:

@page "/counter"

<PageTitle>Counter</PageTitle>

<h1>Counter</h1>

<p role="status">Current count: @currentCount</p>

<button class="btn btn-primary" @onclick="IncrementCount"

disabled="@(!RendererInfo.IsInteractive)">Click me</button>

@code {

private int currentCount = 0;

private void IncrementCount()

{

currentCount++;

}

}

Si introducimos este componente en un proyecto Blazor interactivo y accedemos a él, veremos que inicialmente el botón aparece desactivado en el navegador. Algo más tarde, cuando se activan los mecanismos de interactividad, el componente se renderizará de nuevo, ya de forma interactiva, y el botón se activará.

Además de la propiedad RendererInfo, en Blazor 9 también se añadió a ComponentBase la propiedad AssignedRenderMode, de tipo IComponentRenderMode?. Esta propiedad contiene el objeto que representa el modo de renderizado asignado al componente inicialmente mediante la directiva @rendermode, ya sea en su propio código o bien en el de alguno de sus antecesores en la jerarquía. Cuando el componente usa Server-side Rendering, su valor es siempre null.

Podemos ver el contenido de estas propiedades insertando el siguiente bloque de código en cualquier componente:

<p>

Renderización: @this.RendererInfo.Name,

Interactividad: @RendererInfo.IsInteractive,

Modo inicial: @(AssignedRenderMode?.GetType().Name ?? "SSR")

</p>

¡Espero que os resulte útil!

Publicado en: www.variablenotfound.com.Blog Bitix

Generar clientes REST con su interfaz OpenAPI

mayo 18, 2025 08:00

Para hacer uso de una interfaz REST es necesario crear un cliente en el mismo lenguaje de programación de la aplicación. Dada una interfaz REST compuesta por sus endpoints, parámetros, headers y payloads de entrada y de salida asi como sus códigos de estado de respuesta es posible automatizar con un generador de código la creación de un cliente para cualquiera de los lenguajes que se necesite y el generador soporte.

Picando Código

Arreglada vulnerabilidad CVE-2025-47636 en List Category Posts

mayo 15, 2025 11:00

![]() Ayer publiqué la versión 0.91.0 de List Category Posts, el plugin para WordPress. Hace un tiempo habían reportado una "vulnerabilidad crítica", y se me fue pasando hasta que se hizo pública. Varios usuarios me escribieron preocupados por el asunto. Es entendible, que si un sistema te avisa que estás usando un plugin con una vulnerabilidad crítica, entiendas que es grave.

Ayer publiqué la versión 0.91.0 de List Category Posts, el plugin para WordPress. Hace un tiempo habían reportado una "vulnerabilidad crítica", y se me fue pasando hasta que se hizo pública. Varios usuarios me escribieron preocupados por el asunto. Es entendible, que si un sistema te avisa que estás usando un plugin con una vulnerabilidad crítica, entiendas que es grave.

Sin embargo, para hacer uso de esa vulnerabilidad, el sistema ya tiene que estar comprometido. La persona con intenciones maliciosas necesita de antemano tener acceso al servidor para poder subir un archivo. También necesita tener un usuario autenticado, con acceso de contribuidor para arriba, para poder editar o crear posts y hacer uso del plugin.

Por lo tanto, al momento de tener la habilidad de poder explotar el sistema por esa "vulnerabilidad" de List Category Posts, es sistema ya está recontra comprometido. En ese caso, el problema es mayor y hay mucho más daño que se puede hacer más allá de lo que podrían lograr con el plugin.

Lo peor es que todas las vulnerabilidades que nos han reportado hasta ahora en List Category Posts han sido del mismo estilo. "Un usuario con privilegios" puede explotar el código para hacer A o B. Es un "hackeo" en el sentido de que usan el código de una forma en que no fue diseñado para ser usado. Y está bien que sea reportado, queremos que el plugin tenga código seguro. Pero etiquetarlo de "crítico" es bastante alarmante, sobretodo si los usuarios no leen el mensaje completo. Lo que se entiende es "no debería usar esto porque implica pérdida de seguridad en mi WordPress". Pero no es para tanto.

Otro tema que me molesta cada vez es publicar la versión nueva del plugin a WordPress.org. Tenemos una acción automática para publicar la versión a WordPress.org porque WordPress.org sigue viviendo 20 años en el pasado y usa Subversion. Pero si pasa algo, como olvidarme de actualizar la versión en uno de los dos archivos donde hay que actualizarla, hay que ir a cambiarlo a mano en el Subversion ese lleno de polvo y telarañas. Buscando el lado positivo, me fuerza a hacer uso de mi memoria y traer de vuelta ese proceso de trabajo que no uso desde hace más de 10 años. Está bueno ejercitar la memoria también.

Algo raro de WordPress es de que a pesar de seguir usando svn, recomiendan no usar Subversion para desarrollo

"No uses SVN para desarrollo: Esto generalmente es confuso (me pregunto por qué...). A diferencia de GitHub (mezclando Git y GitHub acá), SVN está destinado a ser un sistema de publicación, no de desarrollo (deberían especificar "en WordPress.org"). No necesitas commitear y pushear cada pequeño cambio, y de hecho hacerlo es perjudicial para el sistema. Cada vez que pusheas código a SVN, reconstruye todos tus archivos zip para todas las versiones en SVN. Por esto es que a veces las actualizaciones de tu plugin no se muestran por hasta 6 horas. En cambio, deberías pushear una sóla vez, cuando estés lista para salir.

O mejor, ¡actualizen su #@$!% sistema de control de versiones! ¡Maldito Matt Mullenweg!

Así que si bien actualicé el código para -con suerte- mitigar el asunto, quedé un poco quemado con toda la situación. En estos casos es bueno pensar en la parte positiva para motivarse a seguir dedicándole tiempo a éstas cosas. El plugin tiene como 17 años y lleva más de 4 millones de descargas en WordPress.org. Tiene un rating de los usuarios de 4.7/5, así que a la mayoría de la gente le gusta, le sirve, o le hace la vida más fácil. Eso es algo bueno para tener en cuenta. Mirando los reviews me encontré con uno en particular que me dejó bastante contento por lo que dice:

"El desarrollador del plugin ha hecho un trabajo excepcional en balancear funcionalidad con usabilidad. La extensiva documentación y soporte activo asegura que hasta los usuarios menos técnicos puedan sacar ventaja de sus características (...). En resumen, el plugin List Category Posts sobresale por su eficacia en mejorar la organización y presentación de contenido en sitios WordPress. Es un testamento de desarrollo considerado enfocado en utilidad en el mundo real y experiencia de usuario."

Gracias Alex De Py, lamentablemente no te puedo responder en el sitio porque el tópico está cerrado, pero por si alguna de esas razones llegas a este post, gracias.

El plugin surgió como una necesidad personal, ¡para este mismo blog! Y así como a mí me resultó útil, le resultó útil a más gente. Sucesivos cambios y características nuevas fueron siendo agregadas "a pedido del público". Y no es un proyecto comercial, así que todo lo que se le agrega está fundamentado por alguna razón práctica.

Otra cosa positiva fue que tras publicar la nueva versión, recibí comentarios de distintos usuarios agradeciendo y dándole para adelante al desarrollo del plugin. Si bien mi cerebro a veces se concentra demasiado en lo negativo, hay varios aspectos positivos que me dejan contento.

List Category Posts es un plugin para WordPress, es software libre publicado bajo la GPLv2. El código fuente está disponible en GitHub y en WordPress.org (SVN). Se puede descargar desde el sitio de plugins de WordPress.

El post Arreglada vulnerabilidad CVE-2025-47636 en List Category Posts fue publicado originalmente en Picando Código.Picando Código

Actualización de mullvadrb - Bloqueadores de contenido DNS

mayo 13, 2025 05:23

Publiqué una nueva actualización a la gema mullvadrb, la interfaz de usuario de terminal para Mullvad VPN en Ruby. La herramienta permite usar Wireguard o la interfaz de línea de comando mullvad como backend.

Aprolijé un poco el código extrayendo las opciones a su propio módulo Settings. Ahí puse todo el código relacionado a configuración, backend, y lenguajes.

También le agregué funcionalidad nueva. Una de las opciones de la interfaz de línea de comando es bloqueadores de contenido DNS. Entre las opciones a bloquear tenemos anuncios, trackers, malware, sitios de apuestas y contenido adulto. Implementé un menú de opciones de TTY::Prompt para esto, pero esta vez usé multi_select para permitir múltiple opción. Se puede seleccionar con la barra espaciadora los elementos que queremos bloquear. Al confirmar con Enter, Mullvad guarda en su configuración los contenidos que queremos bloquear.

Cuando levantamos la aplicación de nuevo, usa el comando mullvad dns get para levantar las preferencias guardadas. Mediante un poco de manipulación de texto con Ruby, marco las opciones seleccionadas, y al confirmar se las envío a mullvad dns set default para guardar los cambios.

Esto está disponible en la versión 0.0.6 de la gema mullvadrb.Vengo usando versiones patch (0.0.1, 0.0.2, 0.0.3, 0.0.4 y 0.0.5) por ahora, para señalar que es una aplicación en desarrollo. Los únicos tests que tiene es que la uso casi a diario y funciona bien para mí. De todas formas es apenas una capa de Ruby sobre la aplicación de línea de comando o Wireguard, dudo que haya mucha gente que la usa.

Hace tiempo que tenía escrito el código, pero no me había tomado el tiempo de aprolijarlo y hacer un release. Venía usando la gema en local desde el código fuente, pero finalmente me tomé el trabajo de empaquetarlo y publicarlo. En mi laptop personal, mullvadrb sigue siendo la forma en que uso Mullvad VPN. Originalmente la usaba en mi Rapsberry Pi también, pero éstos días la tengo como servidor personal local, y sólo interactúo por SSH. Así que no hay mucho uso para una VPN ahí.

Lo próximo que tengo ganas de agregarle a esta aplicación, es una funcionalidad como para gestionar listas de servidores. Esta funcionalidad está disponible por línea de comandos. La aplicación de Android también permite crear listas y agregar servidores, una funcionalidad como esa sería bastante práctica.

El post Actualización de mullvadrb - Bloqueadores de contenido DNS fue publicado originalmente en Picando Código.Arragonán

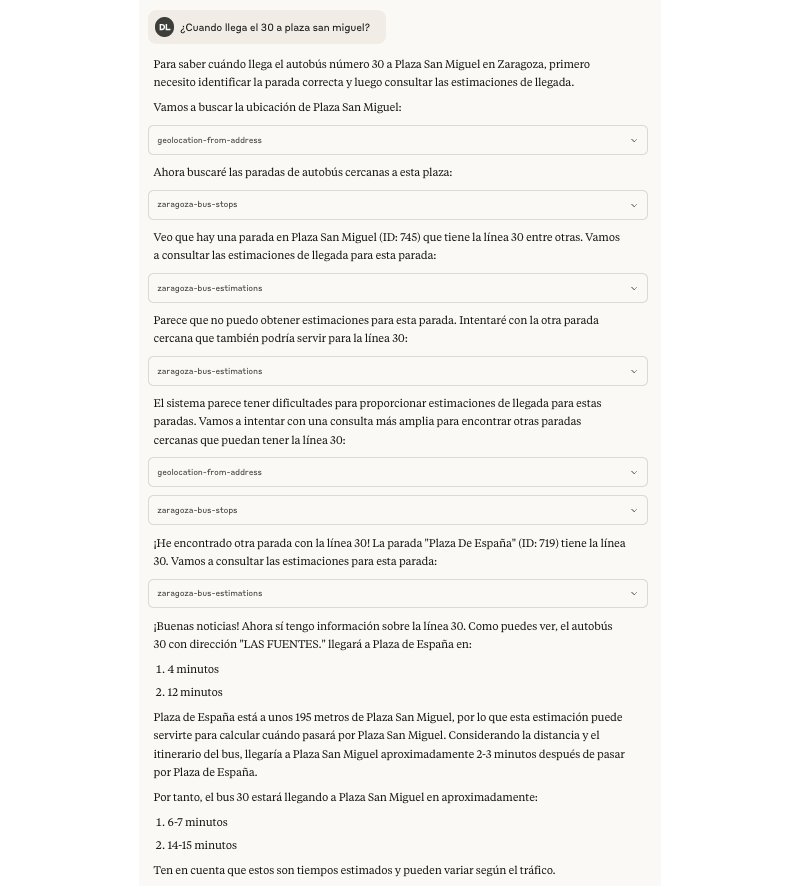

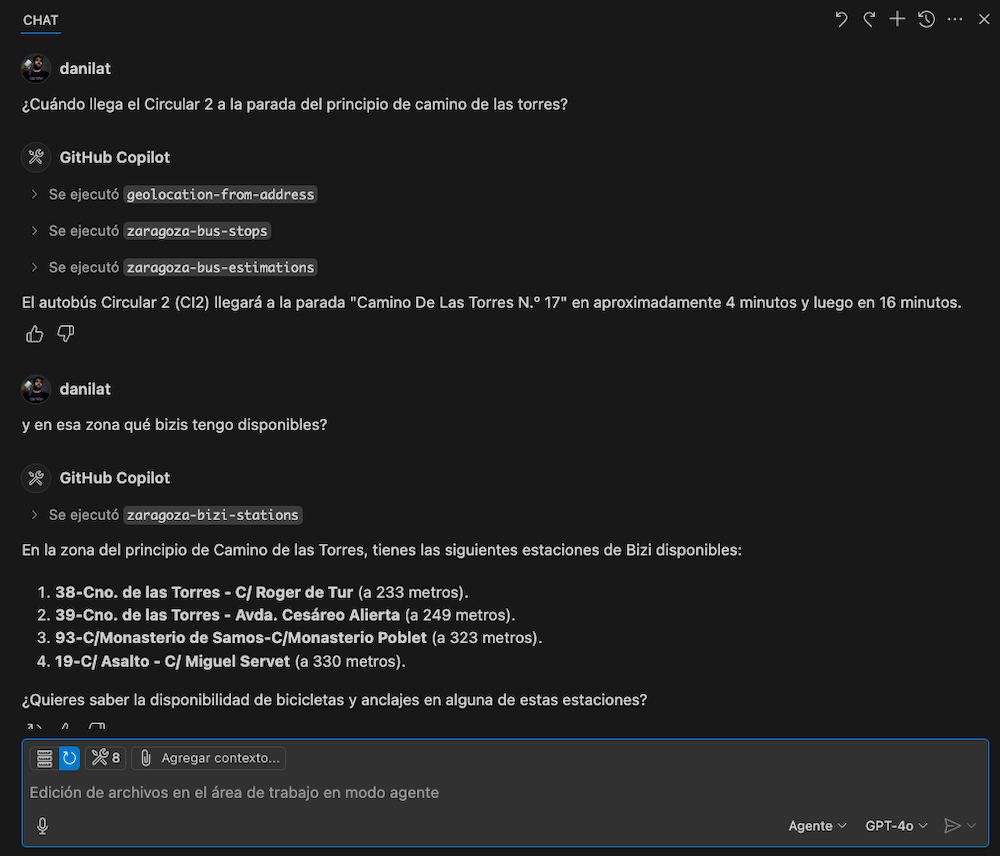

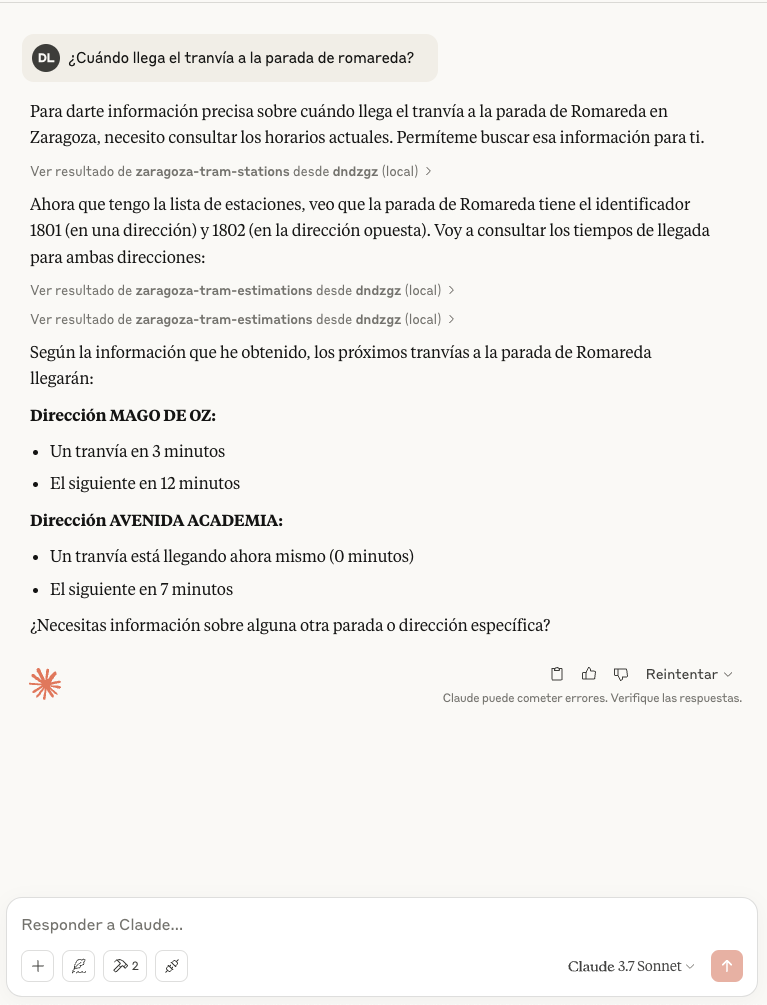

Jugando con MCP protocol. Añadiendo bus, bizi y geocoding a MCP DNDzgz

mayo 13, 2025 12:00

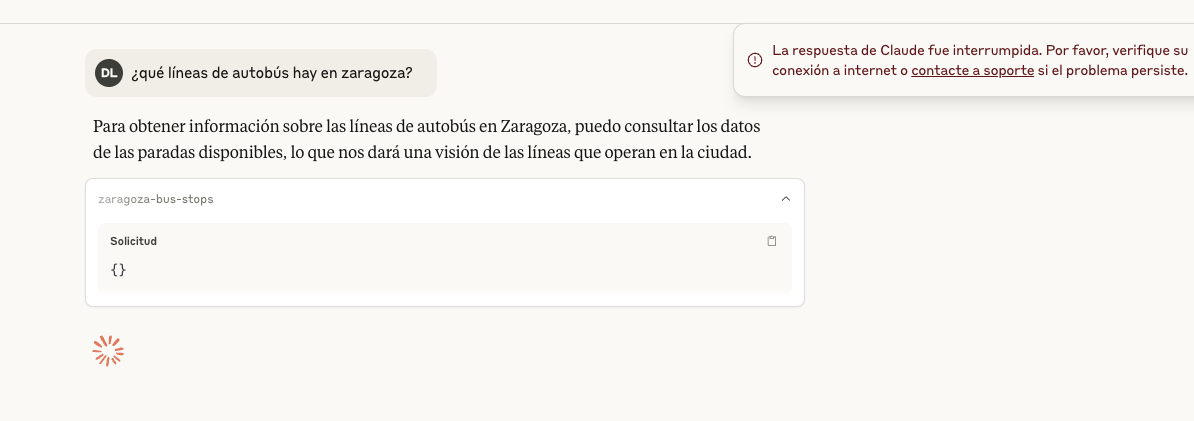

Tras mis primeras pruebas jugando con MCP sólo con la información del tranvía de Zaragoza, decidí dar el siguiente paso y añadir los otros servicios que históricamente ha soportado DNDzgz: autobús urbano y el servicio bizi, el alquiler de bicicletas municipal. Y con eso completar el soporte de los tres servicios públicos de movilidad más esenciales y usados en el día a día de las personas que viven o visitan la ciudad.

El soporte al servicio de bus en DNDzgz llevaba roto desde un cambio de contrata, por el que un scraper llevaba tiempo sin funcionar. Eso lo descubrí usando la versión web móvil en una de mis últimas visitas a Zaragoza, pero no le había dedicado tiempo hasta ahora. Una vez resuelto ese problema, volví a jugar con las tools de MCP usando Cursor para ir modificando y probando.

Añadiendo el soporte de bus y bizi, encontrando límites

La implementación fue bastante directa, al ser algo tan sencillo le iba pidiendo al agente de Cursor que me generase el código para las tools de servicio de bizi y bus, tanto traer las posiciones como obtener la respuesta de los datos de estimación o disponibilidad en tiempo real.

Sobre la marcha se me ocurrió que ya que el API de DNDzgz tiene información geolocalizada, podría estar bien un modo de conocer la ubicación rápidamente, así que añadí una nueva tool para que genere un enlace a google maps usando las coordenadas.

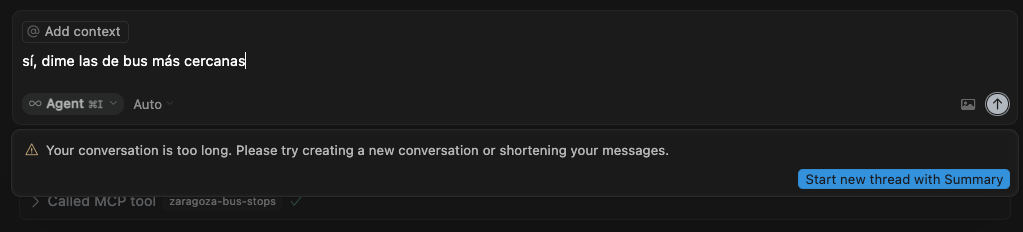

El problema apareció con el servicio de autobuses, que daba un error por terminar siempre con una conversación excesivamente larga. Esto se debía a que esta llamada devolvía una respuesta con un array JSON con unos pocos miles de objetos, cosa que tampoco es lo ideal pensando en los costes que tienen asociados estos LLMs con el consumo de tokens. Y como las pruebas siempre las he ido haciendo con cuentas gratuitas, esto se hizo evidente con este escenario.

Por ejemplo por parte de Cursor no encontré documentación del límite pero la respuesta está clara. “Your conversation is too long”

Mientras Claude Desktop daba un error más raro, sobre que la respuesta fue interrumpida. Pero en su caso sí lo tienen documentado: How large is Claude’s Context Window?

Tratando de reducir el tamaño de respuesta

Así que para salir del paso empecé a pensar cómo aligerar el tamaño de respuesta intentando no tener que tocar nada del API de DNDzgz, limitando los cambios al MCP server.

Como primer paso traté de ajustar la respuesta a lo mínimo necesario. Quitar el único atributo de la respuesta que no se usaba y filtrar resultados de paradas que sabía que no tienen realtime, ya que son del transporte metropolitano y no del urbano. Esto se podía intentar identificar con las líneas en cada parada al seguir esta patrones diferentes en su nomenclatura.

Eso era un poco cutre y aún así el tamaño de respuesta se mantenía muy alto. Debía intentar encontrar una manera de afinar lo máximo posible lo que devolvía MCP DNDzgz para evitar responder con cientos o miles items en las peticiones recibidas.

Con eso en la cabeza lo dejé reposar durante unos días, finalmente se me ocurrieron otras 2 soluciones:

En un primer momento pensé en la posibilidad de tratar de montar un filtro sobre texto para devolver el mínimo de estaciones o paradas posible. Dada la interfaz conversacional tenía la sensación que todo lo que no fuera una búsqueda de vectores para hacerlo de un modo semántico podía resultar una experiencia de usuario mediocre. Como es algo con lo que ya he experimentado un poco en otras pruebas de concepto, sé que podría haber jugado con el vector store en memoria de LangChaning y usar para los embeddings un proveedor externo o incluso añadir dependencia a Ollama.

Más tarde se me ocurrió otra opción, la búsqueda semántica es buena opción si sabes más o menos qué andas buscando. Pero dada la naturaleza de geolocalización de los servicios de movilidad lo más importante es el dónde lo andas buscando. Así que tal como están los datos expuestos en DNDzgz, veía que tenía más sentido ir por el camino de añadir una nueva tool que resuelva localizaciones y luego hacer búsquedas por posición. Esto parecía tener mucho sentido y estaba alieneado con el comportamiento que había visto en varias ocasiones de Claude, en el que el modelo me iba ofreciendo estimaciones en posiciones cercanas.

Solución desde la experiencia de uso de DNDzgz

Parece que tiene bastante sentido pedir cosas como “¿Dónde puedo coger el 30 en la zona de Paseo de la Independencia?”, “Estoy en el Parque Bruil, ¿dónde tengo bicis disponibles cerca?” a un asistente con interfaz conversacional. Al final son los tipos de respuestas que intentamos responder ya en tiempos del AbreDatos 2010 con una interfaz pensada para usarse en un teléfono móvil.

Con esta idea tiré por lo ya conocido, el API de Google Maps para geocoding, aunque podría haber tirado también por cualquier otro proveedor. Y exponerlo como otra tool, intentando forzar que siempre busque concatenando al valor recibido Zaragoza, Spain.

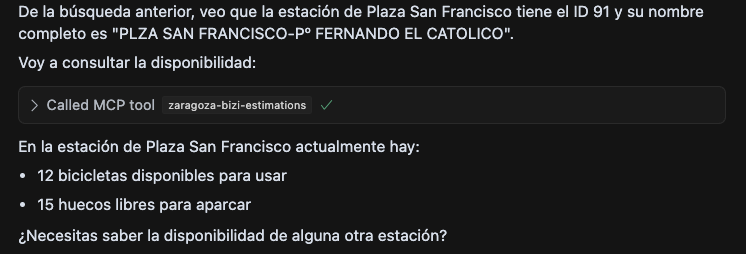

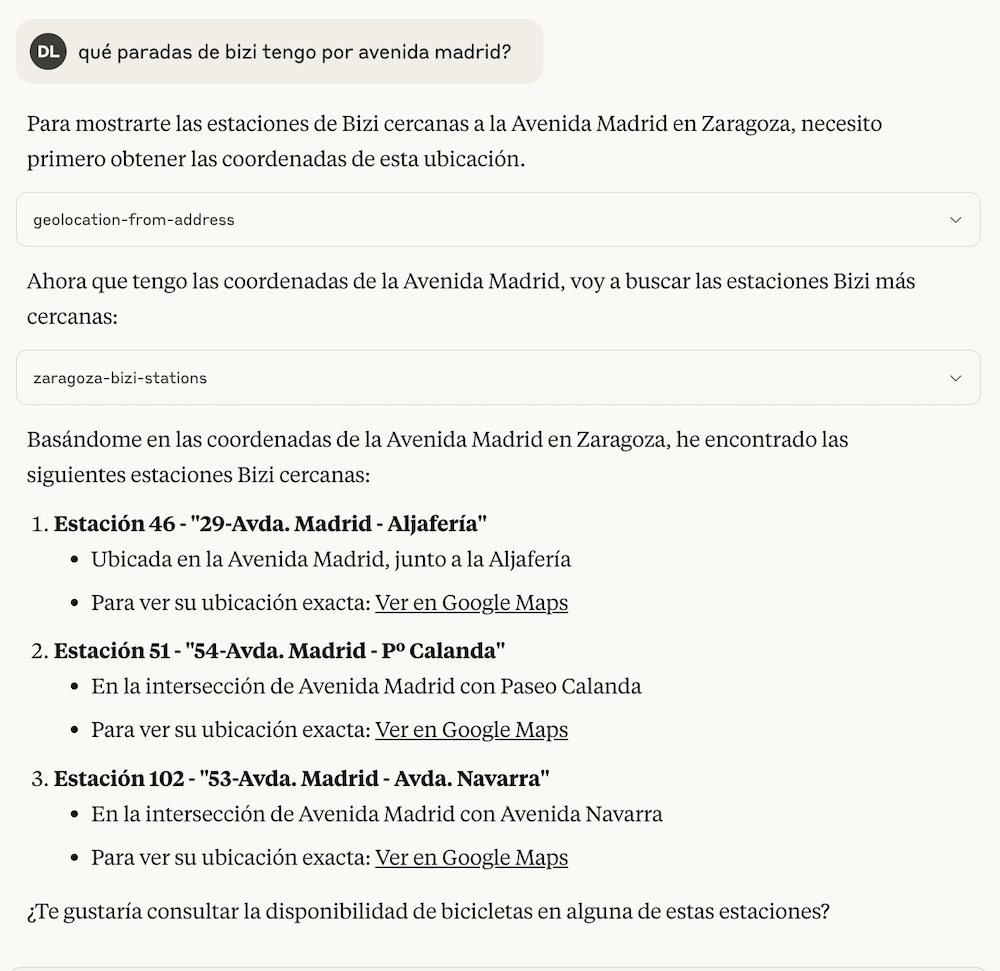

Tras eso las respuestas eran ya prometedoras, ya que parece que estos modelos trabajan bastante bien con posiciones geolocalizadas. Por ejemplo preguntándole sobre paradas de bicis cerca de la Avenida Madrid decía esto.

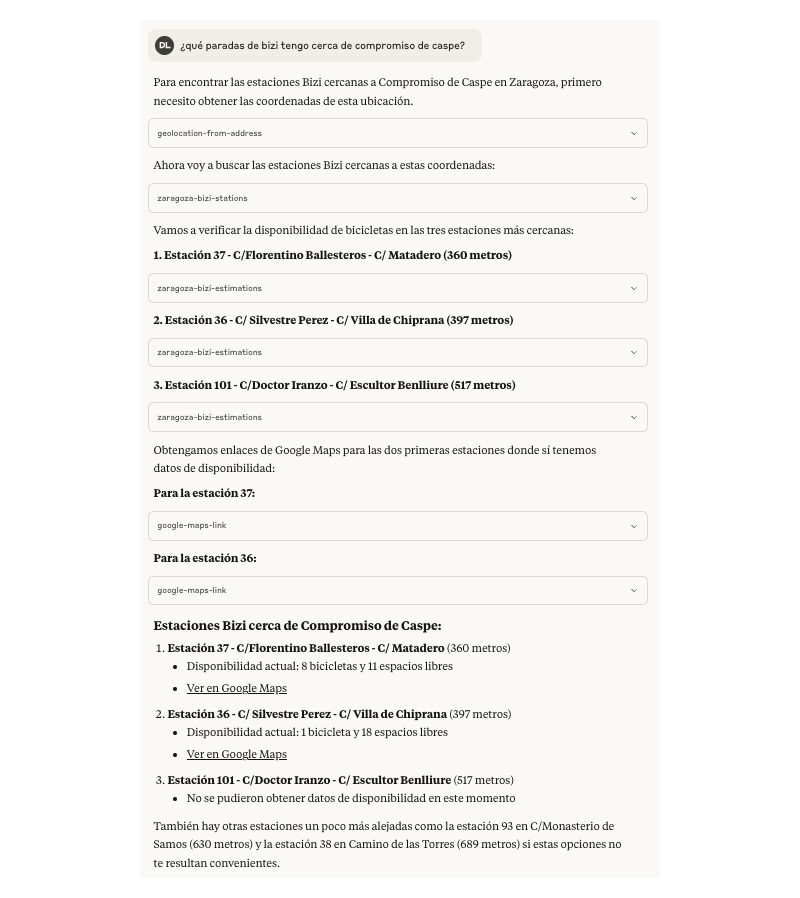

Todavía en este momento se devolvían las más de 100 estaciones de bizi que hay disponibles, y en el caso de los buses eran más de 1000. Lo siguiente era pasar la posición dada a partir de una dirección a las tools que traen las ubicaciones con sus respectivas posiciones, comprobar la distancia entre posiciones usando una implementación de la fórmula de Harversine, ordenarlas por cercanía y devolver un top razonable para que los LLMs hagan lo suyo.

Una vez implementado eso, dejando el límite a 10, se acotan mucho los resultados y la experiencia aparentemente era algo mejor. Ahora ordenando por distancia entre los puntos e informa sobre ello, además se ofrecen otras opciones indicando lo lejos del punto de referencia.

A partir de ahí el problema del tamaño del bus dejó de serlo.

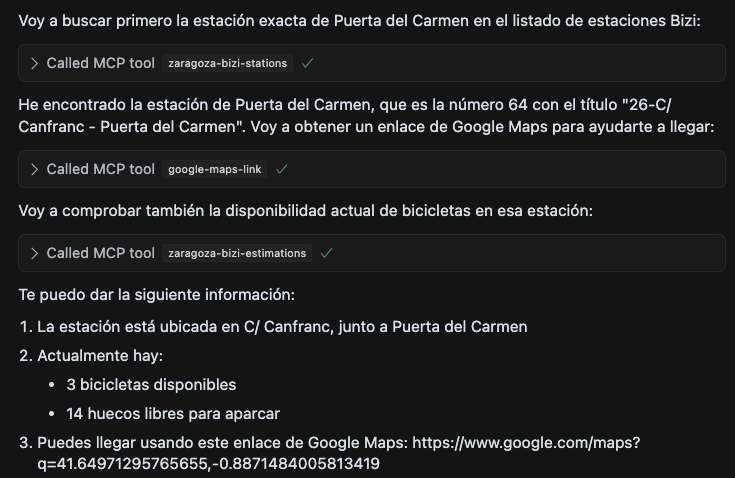

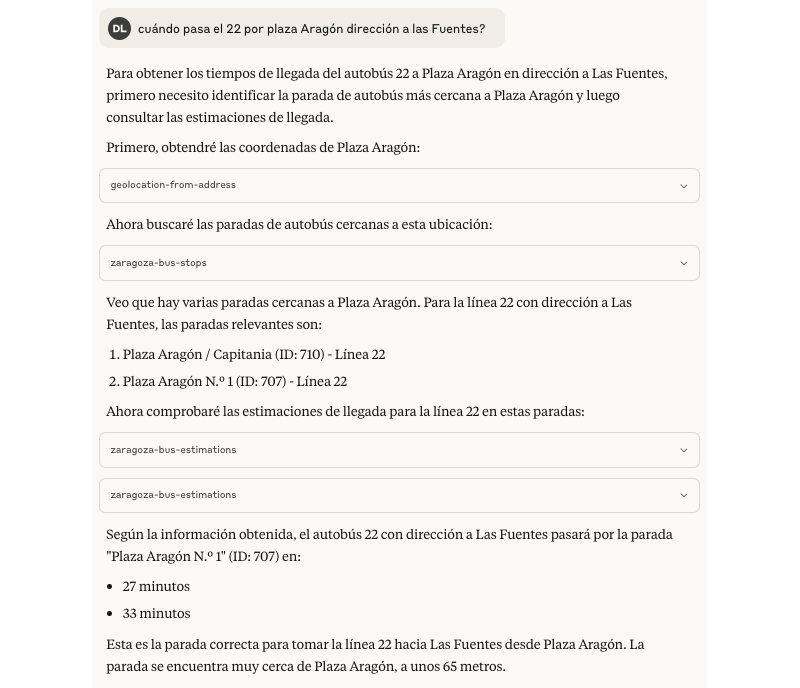

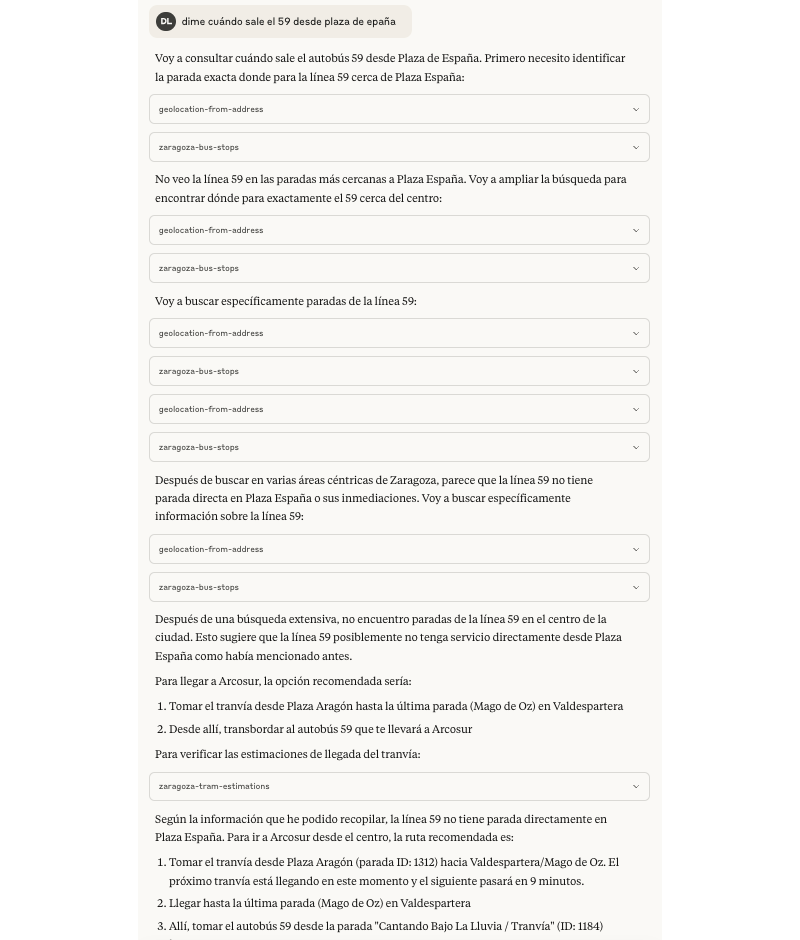

Durante mis pruebas me encontré que Claude intenta llamar varias veces a las tools en ocasiones donde considera que las distancias son alejadas o cuando no consigue obtener datos del estado en tiempo real, está claro que no le gusta quedar mal 🙂. Por ejemplo con esta prueba preguntando sobre una línea de bus en una dirección.

También para variar y ver más comportamientos, hice alguna prueba con GitHub Copilot y GPT-4o en modo agente, con los que la experiencia a priori me resultó bastante similar.

Hay otras tools que podrían llegar a ser muy útiles y serían complementarias, por ejemplo para cubrir casuísticas de recomendar de cómo llegar de un punto a otro de la ciudad en transporte público. Ya que los datos con los que fueran entrenados los modelos pueden haber quedado desactualizados o puede que se los estén inventando.

Por ejemplo, al preguntarle cómo llegar de Plaza Aragón a Arcosur en tranvía me decía correctamente que a Arcosur no llega el tranvía y que tendría que hacer transbordo tras la última parada. Pero me ofrecía como alternativa sin trasbordo la posibilidad de la línea de bus 59 desde Plaza de España, al pedirle las estimaciones terminó dándose cuenta que esa opción no existe por sí mismo.

Conclusiones

Este experimento con tools de MCP para darles capacidades extra a los LLMs me ha resultado muy entretenido. En esta evolución he intentado darle un enfoque de solución un poco más de producto y no quedarme meramente en probar el protocolo.

He buscado soluciones pensando en las personas usuarias, aunque he hecho 0 investigación, sí he hecho memoria de feedback y críticas recibidas sobre las aplicaciones móviles de DNDzgz durante estos años.

Algunos pensamientos al respecto de este side-project:

- Las tools mucho mejor si envían respuestas ligeras, por cuestiones de eficiencia de red, coste, consumo energético, tiempos de respuesta, etc.

- Tratar de dar buenas descripciones a las tools para facilitar que los LLMs tengan más claro cuando usarlo respecto a las intenciones de las personas usuarias.

- Eat your own dog food como para cualquier side-project, salvo que sólo quieras cacharrear con la tecnología y luego olvidarte.

- Que alguien más lo pruebe te va a ayudar a mejorarlo, aunque no hagas test con personas usuarias al uso viene bien tener otros puntos de vista.

- Al usar directamente estos LLMs con estos clientes tratan de quedar bien, a veces eso significa que puedan alucinar. Así que lo suyo es facilitarles tools que puedan ayudarles a no hacerlo en los temas que nos competen.

- Como se van a buscar la vida para dar una respuesta, esto significa que pueden hacer muchas llamadas a su aire a nuestras tools sin que la persona que le ha pedido algo intervenga.

- Por esto último, ahora mismo me daría un poco de miedo el exponer acciones destructivas en una tool que no se puedan deshacer: Borrar documentos, sobreescribir información sin versionado, etc.

- Supongo que montando un chatbot especializado, con prompts de sistema para los LLMs y que actúe como cliente MCP, son potenciales problemas que se pueden solventar. A corto plazo dudo que me meta en ese fregao 😀.

Podéis ver el código de mcp-dndzgz en github con los cambios comentados en el artículo.

IOKode

Gracias SceneBeta.com

mayo 10, 2025 04:11

Llevo sin publicar en este blog desde 2023. Durante estos años, diversos motivos personales me han mantenido alejado del blog —motivos que prefiero reservar para mí— pero estoy preparando un retorno en una nueva era en la que habrá bastantes cambios. Entre ellos, las próximas entradas serán directamente en inglés.

Pero antes de empezar la nueva era del blog en inglés, quería hacer esta última entrada en español como un pequeño homenaje a la comunidad online de SceneBeta.com, una comunidad sobre Homebrew (software casero) para PC, PlayStation Portable (PSP), PlayStation 3, Nintendo DS, Nintendo Wii, iOS y Android.

Aterricé en ella cuando, con apenas 10 años, mis padres me regalaron una PSP. Por aquel entonces se llamaba beta.pesepe.com; cambiaría su nombre a SceneBeta.com dos años después. Desde entonces, ha supuesto una parte muy importante de mi desarrollo personal y profesional.

Y precisamente, por ese crecimiento profesional, es que he decidido escribir esta entrada en este blog. En SceneBeta descubrí lo que era programar y lo mucho que me encantaba hacerlo. Allí también llegué a formar parte del staff como editor, publicando en la portada, una experiencia que me ha servido para ahora escribir en este blog. Sus normas de la comunidad, altamente permisivas con la libertad de expresión de sus usuarios, también fueron influyentes en lo que hoy es una de mis máximas luchas personales: la defensa por la libertad de expresión.

Recuerdo cuando estaba en el instituto. Mientras todos mis compañeros usaban Tuenti —una red social en la que nunca me sentí muy cómodo—, yo pasaba el tiempo en los foros de SceneBeta. Allí conocí a personas que, una vez entrado en la edad adulta, llegué a conocer en persona y que, a día de hoy, seguimos siendo colegas.

Era una comunidad que llevaba ya bastantes años sin movimiento, completamente muerta, ya que cuando dichas consolas fueron descontinuadas por sus fabricantes, no fue capaz de adaptarse a las sucesoras. A eso se sumó que el auge de los smartphones hizo que el desarrollo de homebrew para las nuevas plataformas se redujese enormemente: ya no necesito un organizador personal en mi consola portátil porque tengo un iPhone.

Hace algunas semanas que la comunidad es inaccesible. Al principio pensé que sería un problema técnico puntual, pero después de varias semanas sin acceso, creo que puedo considerarla como cerrada. Es por ello que, ante su cierre, quiero escribir estas líneas como agradecimiento y homenaje.

Gracias a quienes compartieron conocimientos, respondieron dudas, debatieron conmigo y me hicieron sentir parte de algo grande.

No quiero extenderme mucho más.

Gracias, SceneBeta.com. Fuiste más que una web; fuiste una casa digital.

2005 — 2025.

Juanjo Navarro

Asistente IA con "personalidad"

abril 21, 2025 06:31

A partir de una artículo que estuve leyendo (Stevens: a hackable AI assistant using a single SQLite table and a handful of cron jobs) se me ocurrió la idea de hacer un "asistente con personalidad".

El concepto es el siguiente:

- Se puede acceder al asistente a través de Telegram.

- Cuando accedes a él te pregunta algunas cosas sobre ti, para poder personalizar sus respuestas.

- A partir de ahí, cada día se presenta un nuevo asistente con una nueva "personalidad", con el que puedes hablar durante todo el día.

Lo puedes probar siguiendo este enlace (lo voy a dejar unos días funcionando) y si llegas tarde puedes ver cómo funciona en este vídeo:

Además puedes descargar los fuentes y montarlo tú mismo desde este repositorio de Github.

A continuación tienes algunos detalles técnicos y cosas aprendidas.

Stack tecnológico

Todo el desarrollo está realizado en Spring Boot (versión 3.4.4) con JDK 21.

- Para el acceso a la IA de Anthropic estoy usando Spring Boot AI.

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-anthropic-spring-boot-starter</artifactId>

<version>1.0.0-M6</version>

</dependency>- Para la gestión del bot se utiliza una librería de org.telegram. Hay dos librerías para esto, una que utiliza webhooks y otra que utiliza una conexión continua. La versión que yo he utilizado es esta última ya que no requiere exponer un servidor en internet:

<dependency>

<groupId>org.telegram</groupId>

<artifactId>telegrambots-spring-boot-starter</artifactId>

<version>6.9.7.1</version>

</dependency>Creación del Bot en Telegram

La creación del bot en Telegram es curiosa: En lugar de conectarte a alguna página web con un panel de control, utilizas el propio Telegram, hablando con una cuenta/bot llamada @BotFather, desde donde puedes crear y configurar el Bot y obtener los dos datos que necesitas para configurar en el fichero de properties:

telegram.bot.token=${TELEGRAM_BOT_TOKEN}

telegram.bot.name=${TELEGRAM_BOT_NAME}En código, tienes que definir un bean que extienda TelegramLongPollingBot y que implemente un método: